Bewährte Best Practices für Hyper-V-Speicher

<>Speicher ist eine der wichtigsten Komponenten von Servern, darunter auch Virtualisierungsserver, auf denen ein Hypervisor installiert ist und Virtuelle Maschinen laufen. Speicher kann zu hoher oder geringer Leistung führen und die Zuverlässigkeit der Speicherung von VM-Daten und virtuellen Festplatten beeinflussen. In einer virtuellen Hyper-V-Umgebung können verschiedene Speichertypen verwendet werden, und der Administrator sollte vor der Konfiguration eines Servers oder der Bereitstellung von Virtuellen Maschinen die richtige Wahl treffen.

Dieser Blogbeitrag soll Ihnen dabei helfen, verschiedene Arten von Speicheroptionen zu erkunden, um eine Speicherauswahl zu treffen, die für Ihre Umgebung am besten geeignet ist und somit Ihre Anforderungen effizient erfüllt.

Hyper-V-Speicherempfehlungen

Es gibt zwei Arten von Speicher, die auf einem Hyper-V-Server bereitgestellt werden können: lokaler Speicher und Remote-Speicher.

Lokaler Speicher besteht aus mehreren Festplatten, die lokal an den Server angeschlossen sind. Solche Festplatten sind in der Regel über eine SAS-Schnittstelle (Serial Attached SCSI) mit einem RAID-Controller (Redundant Array of Independent Disks) im Gehäuse des Servers verbunden. Die Verwendung von SAS-Festplatten ist gegenüber SATA-Festplatten vorzuziehen (trotz der Kompatibilität – SATA-Festplatten können an SAS-Ports verbunden werden, aber nicht umgekehrt), da SAS-Festplatten eine höhere Zuverlässigkeit aufweisen. Lokaler Speicher kann kostengünstiger sein als Remote-Speicher. Wenn Sie nicht vorhaben, einen Hyper-V-Cluster zu bereitstellen, können Sie lokalen Speicher verwenden.

Remote-Speicher befindet sich separat vom Hyper-V-Server und ist über iSCSI-, Fibre Channel- oder SMB 3.0-Protokolle mit dem Server verbunden. Fibre Channel und iSCSI bieten Speicher auf Blockebene, während SMB 3.0 Speicher auf Dateiebene ist. Fibre Channel erfordert eine spezielle physische Schnittstelle für die Verbindung von Servern mit Speichern wie SAN (Storage Area Network). FCoE (Fibre Channel over Ethernet) kann verwendet werden, um Speicher über Ethernet-Netzwerke zu verbinden. Das iSCSI-Protokoll kann für die Verbindung eines Servers mit SAN oder NAS (Network Attached Storage) verwendet werden. Ein NAS-Gerät sieht aus wie ein Mini-Server mit einem RAID-Controller mit Steckplätzen für Festplatten im Inneren und verschiedenen Ports für die Verbindung mit dem Netzwerk außerhalb. Ein eigenständiger Server kann auch für die Verwendung als NAS konfiguriert werden. SAN und NAS können Datenredundanz für eine höhere Zuverlässigkeit gewährleisten.

Bei der Bereitstellung eines Failover-Clustersmuss ein Remote-Speicher verwendet werden, der von allen Knoten innerhalb des Clusters gemeinsam geteilt wird. In diesem Fall wird ein solcher Speicher als gemeinsam genutzter Speicher bezeichnet.

Verwenden Sie RAID 1 oder RAID 10

RAID ist eine redundante Anordnung unabhängiger Festplatten. Die Datenredundanz auf Ihrem Speicher kann Ihre Daten im Falle eines Festplattenausfalls schützen. Es gibt verschiedene RAID-Typen.

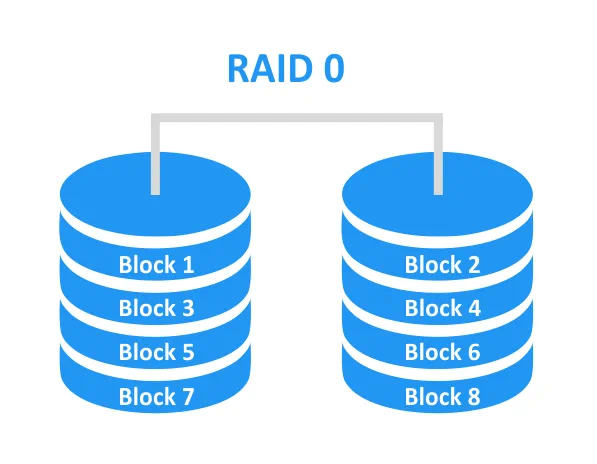

RAID 0 ist nicht redundant und wird als Disk Striping bezeichnet. Es gibt keine Fehlertoleranz – der Ausfall einer Festplatte führt zum Ausfall des gesamten Arrays. Als Verwendungsfall kann die Steigerung der Leistung genannt werden (z. B. Caching von Live-Streams für die TV-Branche). Für den Aufbau dieses RAID-Typs sind mindestens 2 Festplatten erforderlich.

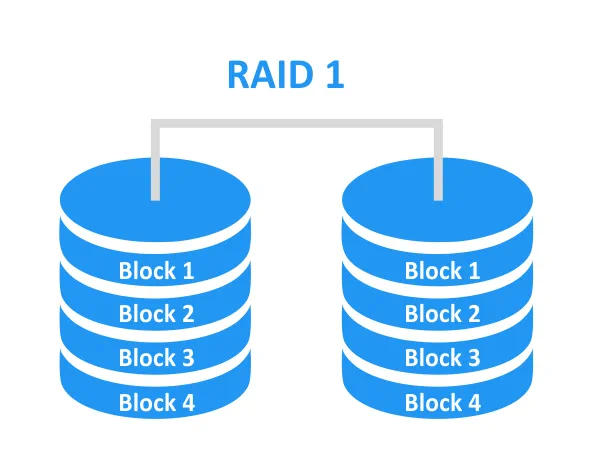

RAID 1 ist redundant. Alle Blöcke auf einer Festplatte werden auf eine andere Festplatte gespiegelt, wodurch eine 100%ige Redundanz erreicht wird. Wenn eine der Festplatten ausfällt, kann auf die Daten auf der zweiten Festplatte zugegriffen und diese zum Wiederaufbau des Arrays verwendet werden. Die Wahrscheinlichkeit einer erfolgreichen Wiederherstellung des Arrays ist hoch. RAID 1 kann für Failover-Speicher verwendet werden. Für den Aufbau dieses RAID-Typs sind mindestens 2 Festplatten erforderlich.

RAID 10 ist eine Kombination aus RAID 0 und RAID 1. Die Vorteile beider Array-Typen werden genutzt, sodass das Ergebnis ein fehlertolerantes Array mit höherer Leistung ist. Die gespiegelten Festplatten werden zu einem Stripe kombiniert. Für den Aufbau dieses RAID-Typs sind mindestens 4 Festplatten erforderlich. Wenn RAID 10 aus 4 Festplatten besteht, können die Daten im Falle eines Ausfalls einer einzelnen Festplatte geschützt werden. Darüber hinaus kann das 4-Festplatten-Array überleben, wenn zwei Festplatten aus verschiedenen Spiegeln ausfallen.

RAID 5 bietet ein Striping mit Parität. Die Blöcke werden über die Festplatten verteilt, aber auch die Paritätsinformationen, die für die Wiederherstellung verwendet werden können, werden über die Festplatten verteilt gespeichert. Der von den Paritätsinformationen belegte Speicherplatz entspricht der Kapazität einer Festplatte. Beispielsweise belegen die Paritätsinformationen bei einem Array mit 4 Festplatten etwa 25 % des Speicherplatzes. Es ist nicht zu 100 % redundant wie RAID 1. Theoretisch kann RAID 5 den Ausfall einer Festplatte überstehen. Für den Aufbau dieses RAID-Typs sind mindestens 3 Festplatten erforderlich.

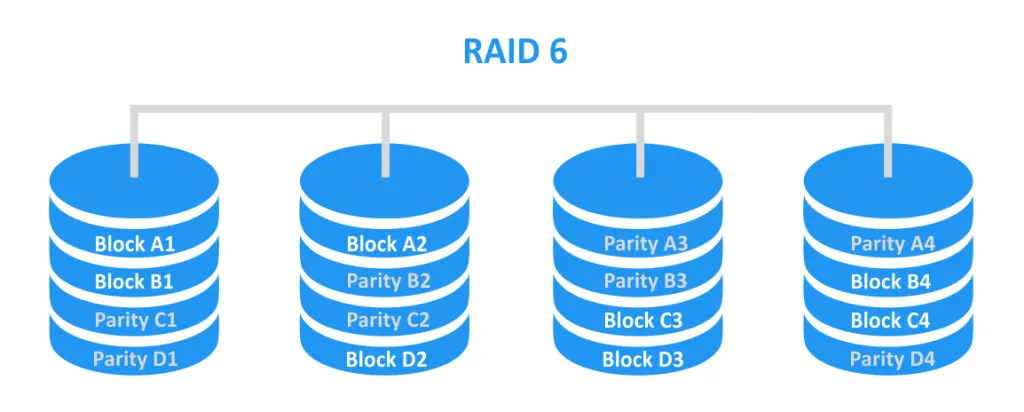

RAID 6 bietet ein Striping mit doppelter Parität. Dies ähnelt dem Konzept von RAID 5, jedoch werden die Paritätsinformationen auf zwei Festplatten statt nur auf einer gespeichert. RAID 6 kann den Ausfall von bis zu zwei Festplatten überstehen. Für den Aufbau dieses RAID-Typs sind mindestens 4 Festplatten erforderlich.

Auf den ersten Blick scheinen RAID 5 und RAID 6 attraktiv zu sein, aber schauen wir uns das genauer an. RAID 5 wurde vor Jahrzehnten entwickelt, als die Kapazität von Festplatten noch recht gering war. In der heutigen Welt wächst die Festplattenkapazität schneller als die Festplattengeschwindigkeit – wenn also eine Festplatte ausfällt, kann die Wiederherstellung von RAID 5 sehr lange dauern. Die Arbeitslast jeder Festplatte in RAID 5 steigt während einer Wiederherstellung erheblich an, insbesondere wenn der Server gleichzeitig intensiv Speicherplatz für die Ausführung regulärer Aufgaben nutzt. Auf den Festplatten, die zu RAID 5 gehören, befinden sich möglicherweise selten verwendete Daten, und Sie können nicht sicher sein, dass diese Daten erfolgreich gelesen werden können. Dies erhöht die Fehlerwahrscheinlichkeit. Wenn während des Wiederaufbaus des Arrays ein Fehler auftritt, kann das gesamte Array ausfallen. Wenn bei RAID 5 eine Festplatte ausfällt, funktioniert dieses Array wie RAID 0 und die Daten sind gefährdet.

RAID 6 verfügt im Vergleich zu RAID 5 über doppelt so viele Paritätsdaten, die für die Wiederherstellung verwendet werden können. Dadurch ist die Wahrscheinlichkeit, den Ausfall einer Festplatte zu überstehen, sowie die Wahrscheinlichkeit eines erfolgreichen Wiederaufbaus höher. RAID 6 hat ein weiteres Problem: Seine Leistung ist im Vergleich zu RAID 10 und RAID 5 am geringsten. Leistungsprobleme machen sich insbesondere während des Wiederaufbaus bemerkbar.

Wie zu sehen ist, bieten RAID 1 und RAID 10 die höchste Zuverlässigkeit, weshalb sie für die Verwendung als Hyper-V-Speicher empfohlen werden. Hardware-RAID kann entweder auf einem physischen Server oder auf einem NAS-Gerät konfiguriert werden.

Nutzen Sie Hochgeschwindigkeitsspeicher

Die Speicher-Eingabe-/Ausgabeleistung hat einen erheblichen Einfluss auf die Bereitstellung einer ausreichenden VM-Leistung. Für die Speicherung der VMs sollten die schnellsten Festplatten (HDD) verwendet werden. Es gibt eine große Auswahl an modernen Festplatten mit hoher Leistung, die eine hohe Geschwindigkeit zu einem erschwinglichen Preis pro Gigabyte bieten. Wenn die Geschwindigkeit einer Festplatte für Ihre VMs nicht ausreicht, können Sie ein Solid State Drive (SSD) verwenden. Im Gegensatz zu klassischen rotierenden Festplatten enthält ein SSD keine beweglichen Teile, sodass ein SSD eine höhere Geschwindigkeit bietet – allerdings ist es auch teurer. Der Preis pro Gigabyte für ein SSD ist höher, und seine Gesamtkapazität ist in der Regel geringer als die einer Festplatte. Durch die Verwendung der Festplatten mit der höchsten Leistung für Ihren Hyper-V-Speicher können VMs ohne Verzögerungen arbeiten.

Verwenden Sie ein dediziertes Volume zum Speichern von VMs

Speichern Sie VMs nicht auf Systemvolumes. Das Systemvolume wird in der Regel zum Lesen oder Schreiben von Systemdateien verwendet, die vom Betriebssystem genutzt werden (C: ist standardmäßig immer ein Systemvolume). Daher kann die Speicherung der VM-Dateien auf dem Systemvolume die Leistung der VM beeinträchtigen. Ein weiteres Problem, das auftreten kann, ist unzureichender freier Speicherplatz auf dem Volume. Diese Situation kann auftreten, wenn Systemdateien den gesamten freien Speicherplatz belegen oder wenn VM-Dateien wie virtuelle Festplattendateien den gesamten Speicherplatz belegen. Infolgedessen besteht die Gefahr, dass die VMs, auf denen Dateien innerhalb eines Systemvolumes gespeichert sind, ausfallen. Darüber hinaus funktioniert der Hyper-V-Host möglicherweise auch nicht ordnungsgemäß, wenn nicht genügend freier Speicherplatz zum Schreiben von Systemdateien vorhanden ist. Verwenden Sie separate Volumes zum Speichern von Betriebssystemen und VMs. Vermeiden Sie außerdem das Speichern von Systemdateien wie Dateien austauschen auf Laufwerken, die für VM-Daten verwendet werden.

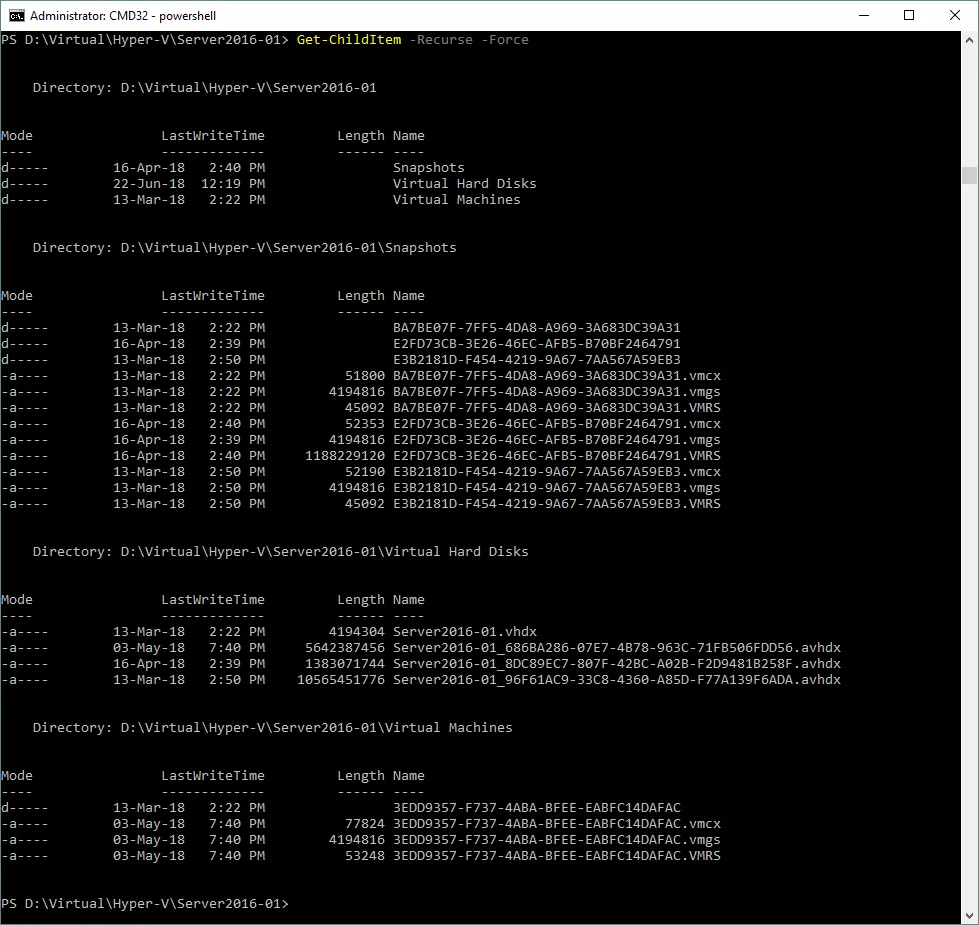

Speichern Sie VM-Dateien an einem Standort

Einige der wichtigsten Dateien der virtuellen Hyper-V-Maschine sind: VHDX (VHD) – virtuelle Festplattendateien, AVHDX – differenzierende virtuelle Festplattendateien, VMCX – Konfigurationsdateien und VMRS – Laufzeitstatusdateien. Die VM-Dateien können an verschiedenen Standardorten gespeichert sein, die für Administratoren ungünstig sind. Um dies zu vermeiden, legen Sie ein einziges Verzeichnis für die Speicherung aller Dateien fest, die zur aktuellen VM gehören. Auf dem folgenden Screenshot ist zu sehen, dass alle Dateien, die zu einer VM namens Server2016-01 gehören, in Unterverzeichnissen eines Verzeichnisses namens Server2016-01 gespeichert sind.

Platz für BIN-Dateien (VMRS) freihalten

BIN-Dateien belegen Festplatte, um den Speicherstatus zu speichern. Zu diesem Zweck sollte auf den Volumes, auf denen die VM-Dateien gespeichert sind, Speicherplatz reserviert werden. Seit Hyper-V 2016 wurde die Erweiterung dieses Dateityps von BIN in VMRS geändert. Dieser Dateityp nimmt nach den virtuellen Festplattendateien VHDX den zweiten Platz beim Speicherplatzverbrauch ein. Die Größe einer BIN- (VMRS-)Datei entspricht der Größe des virtuellen Speichers der VM. Wenn Ihre VM beispielsweise über eine virtuelle Festplatte mit 30 GB und 8 GB virtuellen Speicher verfügt, sollten Sie mindestens 38 GB auf Ihrem Speicher reservieren. Wenn der dynamische virtuelle Speicher für eine VM konfiguriert ist, entspricht die Größe der BIN (VMRS)-Datei der Menge des zu diesem Zeitpunkt bereitgestellten Speichers.

Welches Dateisystem soll verwendet werden: NTFS oder ReFS?

NTFS (New Technology File System) ist ein Dateisystem, das 1993 von Microsoft entwickelt wurde und heute in Windows-Umgebungen weit verbreitet ist.

ReFS (Resilient File System) ist das neueste Dateisystem von Microsoft, das mit Windows Server 2012 freigegeben wurde und folgende Verbesserungen bietet:

- Schutz der Daten vor Beschädigung durch Verwendung von Prüfsummen für Metadaten und Dateien

- Integration mit Speicherplätzen

- Automatische Datenintegritätsprüfung und Fehlerkorrektur (falls ein Fehler auftritt)

- Blockklontechnologie (nützlich beim Klonen von VMs)

- Erhöhte Toleranz gegenüber Stromausfällen

- Support für eine Verschlüsselung mit BitLocker

- Erhöhte maximale Größe der Dateien und Länge des Dateinamens

- Erhöhtes maximales Volumen

- Schnellere Erstellung fester virtueller Festplatten

Wie zu sehen ist, hat das ReFS-Dateisystem eine lange Liste von Vorteilen und wurde entwickelt, um die Anforderungen an den Speicher des Servers effizienter zu erfüllen. Allerdings gibt es auch einige Nachteile:

- Windows kann nicht von einem ReFS-Volume geladen werden

- Datenkomprimierung, Windows-Dateibasierte Deduplizierung, Dateiverschlüsselung, Hardlinks, erweiterte Attribute und Festplattenkontingente werden nicht unterstützt

- Es kann nicht für Clustered Shared Volumes verwendet werden.

- Es bietet kein Support für ältere 8.3-Dateinamen.

Letztendlich liegt die Entscheidung für das Dateisystem beim Administrator. Die Verwendung von ReFS für Hyper-V-Speicher wird empfohlen, wenn die Einschränkungen von ReFS für Ihr System keine Rolle spielen.

Verwenden Sie ein Hochgeschwindigkeits-Speichernetzwerk

Bei der Verwendung von Remote-Speicher ist die Netzwerkverbindung ein entscheidender Faktor. Wenn Sie über Hochgeschwindigkeits-Festplatten in Ihrem NAS oder SAN verfügen, aber eine langsame Netzwerkverbindung haben, würde die Leistung des Speichersystems beeinträchtigt werden. Aus diesem Grund wird die Verwendung eines dedizierten Hochgeschwindigkeitsnetzwerks mit geringer Latenz empfohlen. Um eine akzeptable Geschwindigkeit zu gewährleisten, wird eine 10-Gbit-Netzwerkverbindung empfohlen. Die Verwendung von NIC-Teaming zur Bandbreitenaggregation ist ebenfalls hilfreich.

Vermeiden Sie die Speicherung der VM mit Domänencontroller auf SMB3-Freigabe

Für die ordnungsgemäße Funktion der SMB 3.0-Freigabe ist der Zugriff auf einen Domänencontroller erforderlich. Wenn ein Host mit SMB 3.0-Freigabe oder ein Hyper-V-Host nicht auf den Domänencontroller zugreifen kann, kann die Authentifizierung nicht durchgeführt und keine Verbindung hergestellt werden. In diesem Fall kann ein Hyper-V-Server keine VM mit Domänencontroller starten, die sich auf einer SMB 3.0-Freigabe befindet. Behalten Sie eine VM mit Domänencontroller auf dem lokalen Speicher Ihres Hyper-V-Hosts, um dieses Problem zu vermeiden.

Verwenden Sie Cluster Shared Volumes für die Clusterspeicherung

Bei der Bereitstellung eines Clusters sollten Sie einen gemeinsam genutzten Speicher konfigurieren. Wenn herkömmlicher Speicher ohne CSV verwendet wird, kann jeweils nur ein Knoten (Hyper-V-Host) auf dieselbe Festplatte/LUN zugreifen. Clustered Shared Volumes (CSV) können dieses Problem lösen, indem sie mehreren Knoten gleichzeitig Zugriff auf den Speicher gewähren, ohne dass Volumes neu gemountet und Eigentumsrechte mit Berechtigungen geändert werden müssen. Mit CSV können Sie ein Clustered File System über NTFS oder ReFS für Hyper-V einrichten.

Vermeiden Sie die Verwendung von Pass-Through-Festplatten

Eine Pass-Through-Festplatte ist eine physische Festplatte (LUN), die mit einer virtuellen Maschine verbunden ist. Dieser Festplattentyp wird als Speichergerät verwendet und ist direkt mit dem Festplattencontroller einer VM verbunden. Bei den ersten Versionen von Hyper-V trug die Verwendung von Pass-Through-Festplatten zur Leistungsteigerung bei. Heutzutage sind die Formate virtueller Festplatten so weit fortgeschritten, dass die Verwendung von Pass-Through-Festplatten aufgrund der damit verbundenen Probleme nicht mehr sinnvoll ist. Eine Pass-Through-Festplatte kann nicht einfach mit einer Virtuellen Maschine verschoben werden, und Backup-Software kann kein Backup einer VM mit diesem Festplattentyp auf Host-Ebene erstellen.

Welcher virtuelle Festplattentyp ist vorzuziehen – VHD oder VHDX?

VHD ist ein älteres Format für virtuelle Festplatten für Virtuelle Maschinen, das 2003 eingeführt wurde. VHDX ist ein fortschrittlicheres Format (freigegeben mit Windows Server 2012), das eine höhere Kapazität für virtuelle Festplatten (bis zu 64 TB) bietet, 4-KB-Blöcke unterstützt, eine Live-Größenänderung der virtuellen Festplatte ermöglicht und über eine kontinuierliche Aktualisierung der Metadatenstruktur verfügt, wodurch die Wahrscheinlichkeit einer Datenbeschädigung durch Stromausfall verringert wird. Verwenden Sie daher in Ihrer Hyper-V-Umgebung vorzugsweise virtuelle VHDX-Festplatten.

Die Verwendung von festen und dynamisch erweiterbaren virtuellen Festplatten

Eine feste virtuelle Festplatte ist eine VHDX-Datei (VHD), die den gesamten vorab zugewiesenen Speicherplatz belegt, unabhängig davon, wie viel Speicherplatz innerhalb der virtuellen Festplatte tatsächlich genutzt wird. Die Vorteile der Verwendung einer festen virtuellen Festplatte bestehen darin, dass sie schneller arbeitet, keine Probleme durch Überprovisionierung verursacht werden können und die Fragmentierung der VHDX-Datei nach der Erstellung unverändert bleibt. Die Nachteile der Verwendung einer festen virtuellen Festplatte bestehen darin, dass ihre Erstellung auf NTFS-Volumes länger dauern kann und für die Festplattenerstellung mehr Speicher benötigt wird.

Eine dynamisch erweiterbare virtuelle Festplatte startet nach der Vorbelegung mit einer geringen Größe von wenigen Kilobyte. Diese wächst nach dem Schreiben von Dateien auf die virtuelle Festplatte, bis sie die maximale Größe erreicht, die bei der Festplattenerstellung vorbelegt wurde. Eine dynamische Festplatte kann nicht automatisch verkleinert werden, wenn die Daten auf einer Festplatte dieses Typs gelöscht werden. Die Vorteile der Verwendung dynamischer Festplatten sind, dass sie Platzersparnis bieten, schnell erstellt werden können und Over-Provisioning beinhalten. Die Nachteile sind, dass dynamische Festplatten langsamer als feste Festplatten sind, eine höhere Fragmentierung aufweisen und Over-Provisioning nach dem Wachstum dynamischer Festplatten zu unzureichendem freien Speicher auf dem Speicher führen kann.

Je nach Bedarf können Sie sowohl feste als auch dynamische virtuelle Festplatten verwenden.

Differenzierende virtuelle Festplatten

Eine differenzierende virtuelle Festplatte ist eine virtuelle Festplattendatei (AVHDX oder AVHD), die nach der Erstellung eines Checkpoints im VM-Verzeichnis mit virtuellen Festplatten erstellt wird. Der Zweck der Differenzierung der virtuellen Festplatte besteht darin, Änderungen zu speichern, die nach der Erstellung eines Prüfpunkts auf eine übergeordnete virtuelle Festplatte einer VM geschrieben werden. Eine übergeordnete virtuelle Festplatte kann eine feste, dynamische oder differenzierende Festplatte sein. Wenn ein Prüfpunkt gelöscht wird, wird die mit diesem Prüfpunkt erstellte differenzierende virtuelle Festplatte mit einer übergeordneten virtuellen Festplatte zusammengeführt. Differenzierende virtuelle Festplatten können auch mit dem neuen Assistenten für virtuelle Festplatten von Hyper-V erstellt werden. Es ist wichtig zu beachten, dass die Erstellung einer hohen Anzahl von Checkpoints zur Erstellung immer größerer Differenzierungsfestplatten führt, was zu Leistungseinbußen führt.

Überwachung des Festplattenzustands und der Leistung

Durch regelmäßige Überwachung des Festplattenzustands können mögliche Festplattenschäden verhindert werden, die zu Datenkorruption führen können. Verwenden Sie Dienstprogramme, die S.M.A.R.T.-Daten (Self-Monitoring, Analysis, and Reporting Technology) von Festplattenlaufwerken überwachen können, einschließlich Festplatten, die zu einem RAID gehören. Je früher Sie eine Festplatte mit Problemen identifizieren, desto höher ist die Wahrscheinlichkeit, dass Ihre Daten sicher sind. Die Leistung der Festplatten sollte ebenfalls überwacht werden, um festzustellen, welche Festplatten überlastet sein könnten. Dies kann Ihnen helfen, eine Entscheidung zu treffen, die VMs mit festplattenintensiven Vorgängen auf andere Speicher umzuverteilen, um die Leistung zu optimieren.

Fazit

Speicher ist eine wichtige Komponente für Server, da die darin enthaltenen Daten für die meisten IT-Unternehmen besonders wichtig sind. Der heutige Blogbeitrag befasste sich mit den besten Speicherpraktiken für Hyper-V, die zur Optimierung der VM-Leistung und zur Gewährleistung einer hohen Zuverlässigkeit des Speichers beitragen können. Wählen Sie aus den oben aufgeführten Empfehlungen diejenigen aus, die zu Ihrer Umgebung passen.

Selbst wenn Sie über einen erstklassigen Speicher verfügen, ist es wichtig, Ihre Hyper-V-VM-Daten ordnungsgemäß zum Backup zu sichern. NAKIVO Backup & Replication kann Ihnen dabei helfen, Ihre Hyper-V-VMs auf die effizienteste Weise zum Backup zu sichern.